Weld seam tracking method under strong noise based on kernel correlation filters

-

摘要:

在基于结构光视觉的焊缝跟踪中,焊接时产生的电弧和飞溅等强噪声会大幅降低焊缝的能见度,导致跟踪失败。为了解决这一问题,提出了一种基于改进核相关滤波器的焊缝跟踪算法,以更好地适应强噪声的环境。首先获取焊缝的初始特征点,基于焊缝激光条纹的灰度分布特征,通过Steger算法提取焊缝激光条纹的中心线; 接着对中心线进行滤波并求导来获取焊缝的初始特征点; 最后将焊缝的初始特征点作为初始输入,应用改进的核相关滤波器对焊缝特征点进行学习与跟踪。结果表明,在强噪声干扰的情况下,该算法的平均误差为0.305 mm,最大跟踪误差为0.479 mm,取得了良好的跟踪效果并有效避免了跟踪漂移。该研究为高精度焊缝跟踪提供了有益参考。

Abstract:In the seam tracking based on structured light vision, strong noise such as arc and spatter generated in the welding process would greatly reduce the visibility of the weld, resulting in tracking failure. In order to solve this problem, a seam tracking algorithm based on the improved kernel correlation filter was proposed to better adapt to the strong noise environment. Firstly, the initial feature points of the weld were obtained. Based on the gray distribution characteristics of the weld laser stripe, the centerline of the weld laser stripe was extracted by Steger algorithm. Then the center line was filtered and derived to obtain the initial feature points of the weld. Finally, the initial feature points of the weld were used as the initial input, and the improved kernel correlation filter was applied to learn and track the weld feature points. The results show that, the average error of the algorithm is 0.305 mm, and the maximum tracking error is 0.479 mm in the case of strong noise interference, which achieves good tracking effect and effectively avoids tracking drift. This study provides a useful reference for high-precision seam tracking.

-

0. 引言

光学传感器[1]广泛应用于焊缝跟踪中,其中的视觉传感器通常分为被动视觉传感器和主动视觉传感器两类。本文中采用主动视觉,即结构光的方法,利用电荷耦合器件工业相机与激光发生器来实现焊缝跟踪。

被动视觉的方法一般是利用工业相机在特定滤光片的滤光下捕捉焊缝和熔池的图像,许多研究者[2-4]已将被动视觉应用于熔池检测与焊缝识别。XU等人[5]基于被动视觉提出了一种改进的Canny边缘提取算法,将Canny原有的高斯函数替换为了非线性各向异性扩散滤波器,使得在平滑图像的过程中能够尽可能地保留边缘信息,基于提取的边缘来计算熔池中心与焊缝中心的偏差来实现焊缝跟踪,获得了较高的精度,但实际焊接过程中产生大量的焊接飞溅、电弧、反射等噪声会大大干扰焊缝识别的准确度。BANAFIAN等人[6]提出了一种改进的图像处理方法来识别熔池与焊缝的边缘,采用高频提升滤波器滤波, 使得边缘更加锐利,这种方法在对比实验下虽然取得了较高的精度,但其时间成本过高,在处理高质量图片时无法实现实时跟踪。XIA等人[7]提出了一种基于窗口信息融合的焊缝跟踪算法以及局部特征移动窗口识别算法来提取焊缝的凹槽中心,并采用卡尔曼滤波对其偏差进行最优估计,此方法以实时性和准确性实现了焊缝的跟踪。ZHANG等人[8]建立了基于拼接光学图像的虚拟焊接环境模型,提出了一种基于高斯过程的模型预测控制方法, 其相较于传统方法,具有更小的噪声敏感性,同时能够以每秒50帧的速度处理焊缝数据,完全满足实时性的要求。

主动视觉的方法通常是利用工业相机在特定滤光片的滤光下捕捉打在焊缝上的线结构光,线结构光往往是由激光光源产生,激光条纹样式应用最多的则是单线与多线激光。主动视觉的方法能够减少飞溅和电弧的影响,同时使焊缝的特征在图像中更加清晰。由于焊缝的特征更为明显,深度学习也就自然引入到焊缝跟踪中来,参考文献[9]中采用深度学习的方法来进行焊缝检测,深度学习均是应用在特征点的识别。参考文献[10]中利用语义分割卷积网络,针对焊缝的多轮次焊接,创造性地将噪声与激光条纹分开用于训练,将激光条纹置于距焊枪仅25 mm处,这是一个相当近的距离,此时图像中会出现非常强的噪声,即在强噪声环境下进行焊缝跟踪。参考文献[11]中利用卷积神经网络来获取多种焊缝的特征点,并引入了非典型焊缝这一概念。此外,WANG等人[12]利用拉普拉斯高斯滤波器(Laplacian of Gaussian filter)对第1帧图像的中心线进行提取,由于考虑了激光条纹的宽度,因此可以减小某些飞溅噪声的影响;而后利用非均匀有理柱条曲线Snake模型对初始轮廓进行迭代,通过将能量最小化来确定焊缝轮廓位置,再根据迭代自适应算法去除冗余特征点,最后采用随机采样一致进行焊缝拟合, 但此方法对需要多次焊接的焊缝是无法完成持续检测跟踪的。在大型工业场合的焊接工作,一般都是要多次焊接才能将焊缝焊接完成,多次焊接即意味着每一轮焊接都有不同的特征点,这使得传统方法难以长时间准确跟踪, 参考文献[13]中对此进行了研究。参考文献[14]中运用传统图像处理,经过滤波、阈值分割、去噪、细化、曲线拟合、特征点提取这6个步骤后获取特征点位置,但其处理速度也受限于自己的算法,难以实现实时处理。

本文作者针对强噪声干扰环境下的多次焊接,提出了一种基于改进核相关滤波器(kernel correlation filter,KCF)的焊缝跟踪算法。该算法能够有效地减少强噪声的干扰,首先通过Steger算法完成初始焊缝位置的提取,而后利用改进的KCF算法进行焊缝跟踪。这种算法能够很好地满足跟踪的实时性, 甚至达到高速,并能以较高的准确率完成焊缝跟踪。

1. 视觉传感系统与系统框架

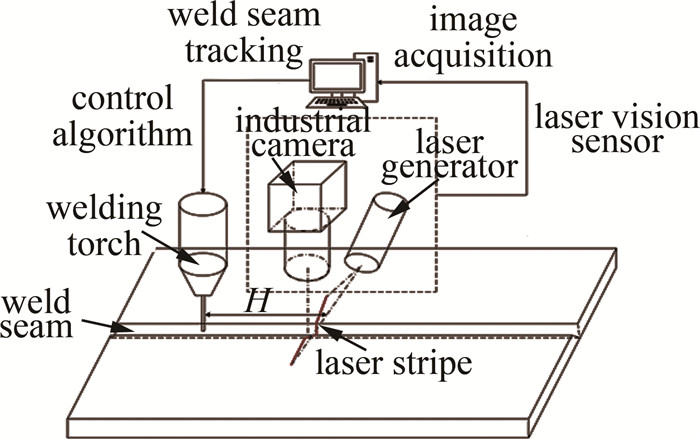

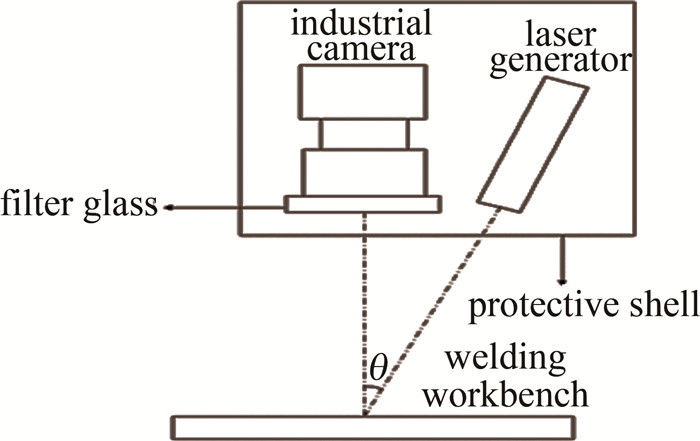

如图 1所示,结构光视觉传感器由工业相机、激光发射器、滤光片与保护外壳组成。为了保证工业相机采集到的图片的质量,工业相机与激光发射器呈30°进行安装,其在工作时与焊缝工作台的距离约为120 mm。

整个系统的工作框架如图 2所示。计算机负责接收结构光传感器获取的图像,完成焊缝特征点的提取进而完成焊缝跟踪,最后通过控制算法向机器人发出控制指令。激光条纹打在工业相机正下方,焊枪与激光条纹之间的距离定义为H,H越小则捕捉到的图片含有的噪声越大, 相应的跟踪时滞也会减少。本文中焊缝跟踪在强噪声环境下进行,因此H要尽量的小,实验中通过调节传感器的底座来调整焊枪与激光条纹之间的距离,使H≈30 mm。焊接过程中的电弧和飞溅的干扰是很强的,甚至会覆盖激光条纹的重要部位而使得焊缝特征点检测失败,通常需要在工业相机的镜头前加上滤光片过滤掉大部分噪声。根据对气体金属弧焊(gas metal arc welding,GMAW)的光谱分析[15],GMAW焊在400 nm、550 nm、800 nm附近的电弧较强,而在610 nm~700 nm波长范围内电弧较弱且稳定,中心波长为660 nm的滤光片与激光发射器最适合此场景下的焊缝跟踪。因此实验中选择波长为660 nm的红光激光器与中心波长为660 nm、带宽为20 nm的带通滤波器(滤光片)。焊接开始之前还要进行标定,通过相机标定、机器人手眼标定和结构光平面标定,获得图像中的2维坐标到空间3维坐标的转换关系[16],这是实现后续焊接路径规划并向机器人发出控制指令的关键。

2. 焊缝跟踪算法设计

2.1 初始特征点的提取

本文的核心要素是基于KCF的焊缝跟踪,为了实现基于KCF的焊缝自识别与跟踪,初始焊缝特征点的获取就成了首要任务。初始特征点将作为KCF算法的初始跟踪目标,亦是初始参考位置,因此必须确保此步的准确性。本文作者采用的初始特征点的提取有3个步骤,分别为:组合滤波、焊缝光条中心线提取与特征点提取。

2.1.1 组合滤波

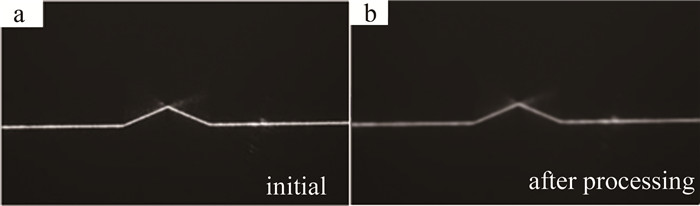

在强噪声环境下,对不同类型的焊缝光条中心线提取是十分困难的,应先对初始帧进行组合滤波处理。组合滤波需要对工业相机采集到的焊缝图片进行局部加权散点平滑滤波,而后进行中值滤波与高斯滤波。局部加权散点平滑滤波为加权线性最小二乘结合1阶多项式模型,能较好地平滑处理波动性数据,用于处理焊件表面毛刺等失真;中值滤波能较好地去除椒盐噪声;高斯滤波能抑制来自正态分布的干扰信号,同时可以将激光的截面光强分布变为较为理想的正态函数。初始V型焊缝如图 3a所示, 进行组合滤波后得到的效果如图 3b所示。

2.1.2 焊缝光条中心线提取

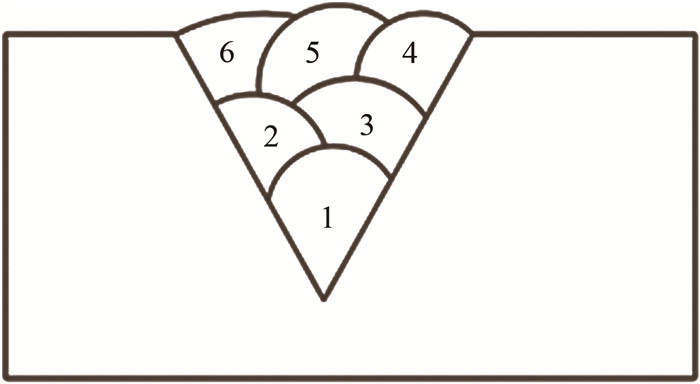

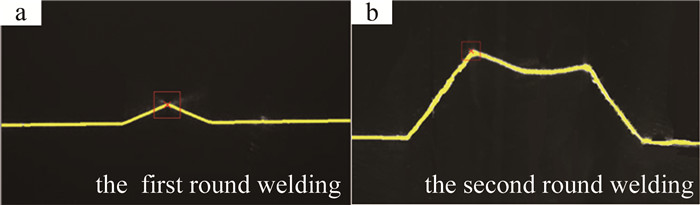

焊缝光条中心线提取的核心是基于Hessian矩阵的Steger算法[17]。本节中拟实现多种焊缝类型的初始焊缝光条中心线提取。在实际工业焊接中,焊缝并不能通过简单的一轮焊接就能完成,而是要经过多次焊接。本文中研究的多次焊接的V型焊缝如图 4所示,每一轮焊接都使焊缝形状变化。常见的焊缝类型还有对缝焊缝、搭接焊缝、非典型焊缝[18]等。

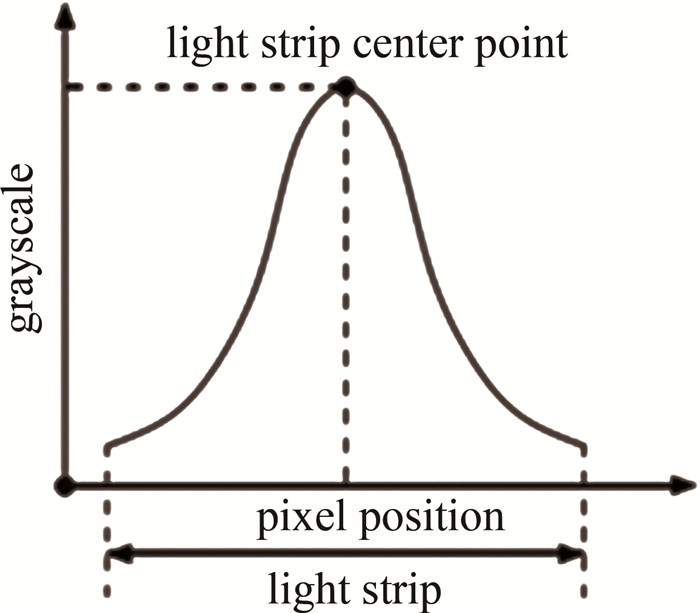

激光器发出的线结构光,在本质上是一个连续的且具有一定厚度的空间光平面,因此激光打在目标表面上时会具有一定宽度的光条特征,在空间光平面厚度的方向上,光的强度是近似服从高斯分布的,即光条中心的灰度值大而光条边缘的灰度值小,如图 5所示。

基于Steger算法,定义当前像素坐标(u0, v0)处的光强值为I(u0, v0),沿光条法线方向e=[eu, ev]的光强分布,即灰度值多项式函数I(u0+t·eu, v0+t·ev)经泰勒展开为:

\begin{gathered} I\left(u_0+t \cdot e_u, v_0+t \cdot e_v\right)=I\left(u_0, v_0\right)+ \\ t \cdot \boldsymbol{e} \cdot\left[\frac{\partial I}{\partial u}, \frac{\partial I}{\partial v}\right]^{\mathrm{T}}+\frac{t^2}{2} \cdot \boldsymbol{e} \cdot \boldsymbol{H}(u, v) \cdot \boldsymbol{e}^{\mathrm{T}} \end{gathered} (1) 式中: [\partialI/\partialu, \partialI/\partialv]为1阶偏导数; H(u, v)为Hessian矩阵; t是一个未知参数。Hessian矩阵的最大特征值(uu, vv),即为光强变化最快的方向。当前坐标附近的光强分布函数可以看作是一个关于t的分布函数,对t求导并令其导数为零,此时得到的坐标值即为光强最强的地方,亦即激光中心点。当t·eu与t·ev均小于0.5时,则光强最大值点就在这个像素内。

t=-\frac{e_u \cdot \frac{\partial I}{\partial u}+e_v \cdot \frac{\partial I}{\partial v}}{e_u{ }^2 \cdot \frac{\partial^2 I}{\partial u^2}+2 \cdot e_u \cdot e_v \cdot \frac{\partial^2 I}{\partial u \partial v}+e_v{ }^2 \cdot \frac{\partial^2 I}{\partial v^2}} (2) 经过两轮焊接的光条检测的结果如图 6a和图 6b所示。黄色区域代表检测的焊缝光条,特征点即需要跟踪的焊缝用红色方框于图中进行了标注。对比图 4与图 6b,经过一轮焊接后,原有的V型焊缝发生了变化,以单特征点为标准,选取焊缝底部,即红色方框标识的位置为特征点。

2.1.3 特征点提取

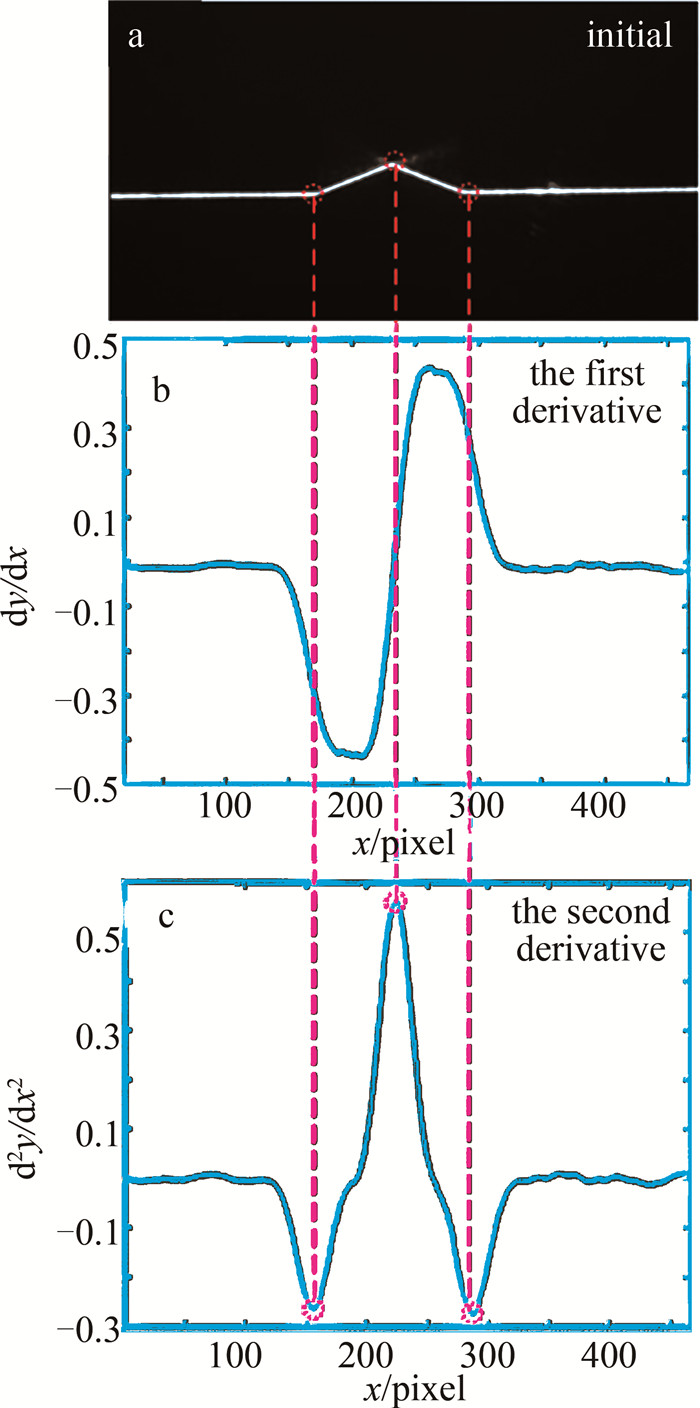

特征点位于检测到的焊缝光条中心线上,考虑到焊接的实际情况,选用寻找单特征点的方法。这种方法使得特征点可以直接对应被跟踪的焊缝,即焊枪的理论位置。通过在2.1.2节中获取的焊缝光条中心线,以初始焊缝为例(见图 7a),对光条中心线中每个点求1阶导数与2阶导数,求导的同时平滑导数曲线,平滑后的1阶导数与2阶导数如图 7b与图 7c所示,通过求导获取全局极值来获取候选的特征点[19],最后基于坐标关系确定焊缝特征点。如果针对斜率更大的焊缝,则导数斜率变化会更明显,也因此本方法将会有更高的精准度。图中,纵坐标dy/dx代表光条中心线中每个点的1阶导数,d2y/dx2代表光条中心线中每个点的2阶导数。

2.2 焊缝特征点的目标跟踪算法

合适的目标跟踪算法是影响焊缝跟踪的主要因素。因此,在强噪声焊接环境中,本文中采用KCF[20]进行焊缝的实时跟踪。KCF算法是目前主流的视频目标跟踪算法,广泛应用于运动识别、自动视频监控、视频检索等领域[21]。其跟踪的关键是基于序列图像中的视频信息的时空相关性,以上一帧的目标为基础训练当前帧的跟踪模板,即在同一视频的每一帧中为目标分配相应的标签以确定目标的位置。相对于传统图像处理或者机器学习的方法,KCF应用了快速傅里叶变换(fast Fourier transform, FFT),有着极快的处理速度,同时KCF在获取正负样本进行训练分类器时采用了循环矩阵,并利用循环矩阵在傅里叶空间中的可对角性,将矩阵的运算变为了向量元素的点积。在特征提取方面,摒弃了原来的单通道特征,采用多通道的方向梯度直方图(histogram of gradient, HOG)。

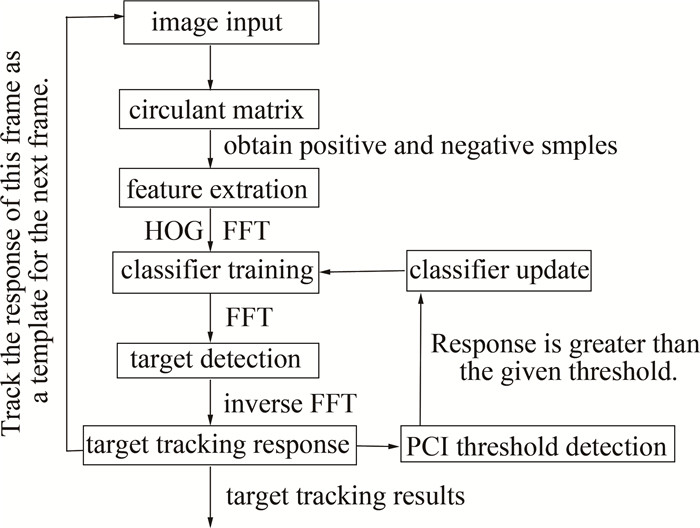

传统的KCF跟踪算法在较为理想的情况下能够以每秒数百帧的速度跟踪物体,但在实际应用中其局限性也逐渐显现出来。第1个是KCF的尺度自适应[22-23]问题,当跟踪目标由近至远变化时,其大小尺度会发生变化,这种变化可能会导致KCF跟踪失败,但在本文中,焊枪与焊接平面的距离相对固定,不存在尺度变化问题; 第2个是KCF对跟踪目标被遮挡的情况时,没有目标丢失预警机制,目标丢失会影响跟踪结果的可靠性,当跟踪目标被不同程度地遮挡时,分类器会基于被遮挡的目标更新模型,最终导致跟踪漂移[24]发生。为了解决这些问题,本文作者提出了一种改进的KCF算法,其算法流程如图 8所示。

KCF算法的核心就是要训练一个分类器,使用岭回归函数找到这样一个函数: f(Z)=wTZ, 使得误差函数最小,即找到一个权向量w使得误差函数最小。其中,Z代表一个输入特征向量。本文中误差函数为:

\min _\boldsymbol{w} \sum\limits_i\left[f\left(x_i\right)-y_i\right]^2+\lambda\|\boldsymbol{w}\|^2 (3) 式中:xi表示特征值;yi表示回归值;λ是防止过拟合的正则化参数。式(3)的解为:

\hat{\boldsymbol{w}}^*=\frac{\hat{\boldsymbol{X}}^* \odot \hat{\boldsymbol{Y}}}{\hat{\boldsymbol{X}}^* \odot \hat{\boldsymbol{X}}+\lambda} (4) 式中:向量X由xi组成; 向量Y由yi组成; \hat{\boldsymbol{X}}是X的傅里叶变换; X*是X的共轭矩阵; ⊙是向量乘法。本文中采用高斯核函数来提高分类器的性能, 并将输入X映射到特征空间φ(X),令核函数k(X, X′)=φT(X)· φ(X′),则高斯核函数可以表示为:

k\left(\boldsymbol{X}, \boldsymbol{X}^{\prime}\right)=\exp \left(-\frac{1}{\sigma^2}\left\|\boldsymbol{X}-\boldsymbol{X}^{\prime}\right\|^2\right) (5) 式中:X′是另一组特征向量; σ是高斯核函数的带宽参数。分类器的权重向量w可以表示为:

\boldsymbol{w}=\sum\limits_i \alpha_i \varphi\left(\boldsymbol{X}_i\right) (6) 则需要求解的参数的解从w变为α,α ={α1, α2, …, αj, …}T,最终的回归函数变为:

f(\boldsymbol{Z})=\boldsymbol{w}^{\mathrm{T}} \boldsymbol{Z}=\sum\limits_{j=1}^n \alpha_j k\left(\boldsymbol{Z}, \boldsymbol{X}_j\right) (7) 获得其最大值后,在新的一帧图像中,所需特征点的2维像素坐标(ci, ri)为:

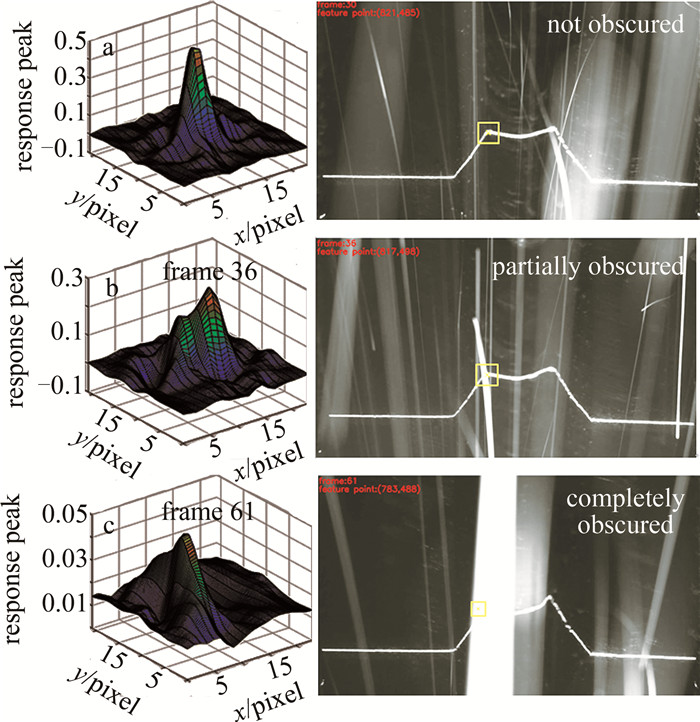

\left(c_i, r_i\right)=\max \boldsymbol{f}_{\mathrm{m}}^{-1}\left(\boldsymbol{f}_{\mathrm{m}}\right) (8) 式中:fm为f(Z)的矩阵形式; fm-1是fm的逆函数。当特征点坐标确定后,回归函数的模型就会进行更新,以适应后续跟踪,即KCF通过相邻两帧之间的相关度响应值来确定跟踪目标。但经过实验发现,当焊缝出现遮挡的情况时,相邻两帧之间的相关度响应会出现异常。未遮挡、部分遮挡和完全遮挡目标的3维相关度响应峰值图如图 9所示。图中, x轴与y轴分别表示感兴趣区域内的像素坐标,纵轴表示相关度响应峰值。

通过对比图 9a、图 9b和图 9c可知,当焊缝出现遮挡时,响应峰值会减小,峰值附近会出现不同程度的侧扑,即峰值周围的响应值增大。因此,响应峰值的大小可以用来对跟踪目标的遮挡情况进行判断。然而,经过大量测试发现,极少数遮挡情况下的反应峰值反而会很高,因此不能仅仅依靠响应峰值来确定目标是否被遮挡。

基于上述发现,本文作者采用传统KCF算法, 在焊缝跟踪场景下提出了一种目标丢失预警机制,利用响应最大值、最小值以及当前帧响应均值来衡量目标的跟踪状态。定义一个峰值相关指数(peak correlation index, PCI)用来表征响应图的波动程度:

I_{\mathrm{PCI}}=\frac{\left(C_{\max }-C_{\min }\right)^2}{A\left(\sum\limits_{i, j}\left[C(i, j)-C_{\min }\right]^2\right)} (9) 式中: A(·)为当前帧响应均值函数; Cmax为相关度响应的最大值; Cmin为相关度响应的最小值; C(i, j)为位置(i, j)处的相关度响应值。当焊缝出现不同程度的遮挡情况时,IPCI值会相应的减少。实验中定义: 只有Cmax与IPCI高于一定阈值时分类器才进行模型更新,避免了跟踪模型受到影响,进一步提升目标跟踪的准确度,避免了跟踪漂移的发生。

当Cmax与IPCI高于响应的给定阈值时,α与目标模型X将会按如下公式进行更新:

\left\{\begin{array}{l} \hat{\boldsymbol{\alpha}}=(1-\beta) \hat{\boldsymbol{\alpha}}_{i-1}+\beta \boldsymbol{\alpha}_i \\ \hat{\boldsymbol{X}}_i=(1-\beta) \hat{\boldsymbol{X}}_{i-1}+\beta \boldsymbol{X}_i \end{array}\right. (10) 式中: β为学习系数, 且0 < β < 1。在上一帧与当前帧的处理中,\hat{\boldsymbol{\alpha}}_i与\hat{\boldsymbol{\alpha}}_{i-1}分别为基于α的系数更新,\hat{\boldsymbol{X}}_i与\hat{\boldsymbol{X}}_{i-1}分别为基于系数Xi的系数更新。

3. 实验与分析

焊接系统主要由焊接机器人、个人计算机以及结构光传感器组成,系统图如图 1所示。传感器采样频率为30 Hz,采集的图像尺寸为1920 pixel×108 pixel。采用660 nm±20 nm的滤光片减少电弧干扰。算法运行环境为AMD 4800H CPU,内存大小为16 GB,显卡型号为GTX 1660Ti。为了验证算法的有效性,共测试了数千张焊缝焊接图片,基于图片的连续性将图片分为多组进行测试验证,在后续的实验分析中,图片将会有其对应的帧数,但未必来自同一组焊缝焊接图片。

3.1 强噪声下的焊缝跟踪及误差分析

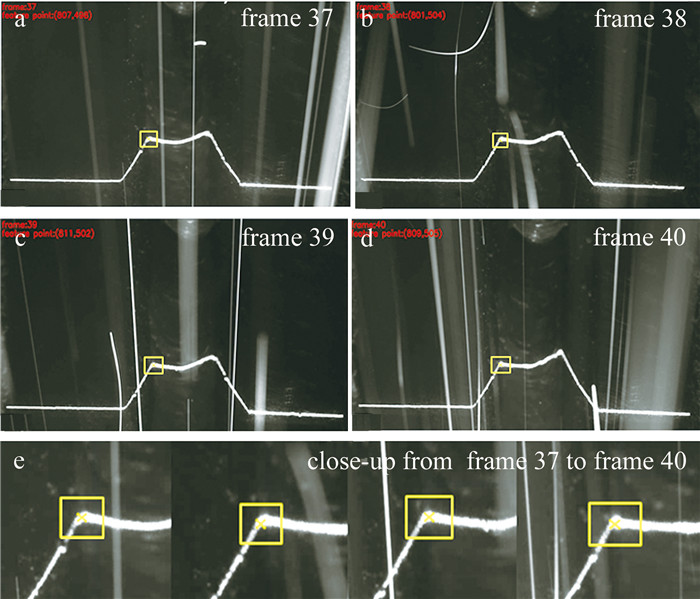

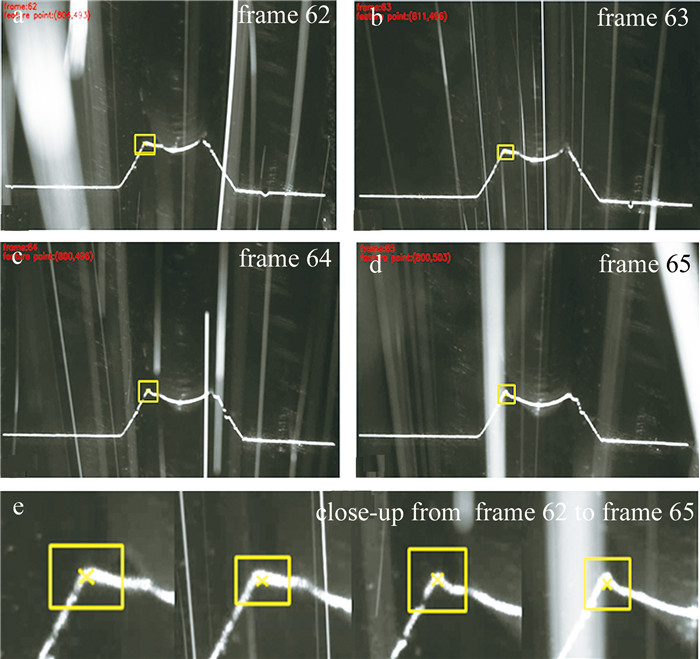

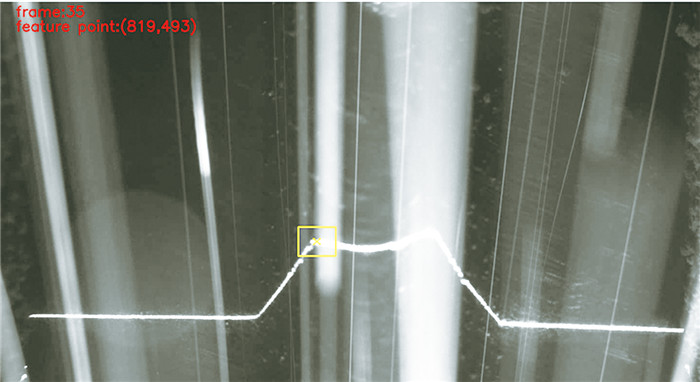

图 9b和图 9c中给出了目标出现遮挡的第36帧和第61帧属于强噪声的情况,在加入PCI的KCF算法下进行了后续的焊缝跟踪实验。实验中定义PCI的阈值IPCI, th=5.2,相关度响应阈值Cth=0.3。当IPCI>IPCI, th且Cmax>Cth时模型才会更新,实验结果截取目标出现遮挡后的后面4帧结果,如图 10与图 11所示。获取的焊缝感兴趣区域由黄色方框框出,焊缝特征点由黄色十字标注,与此同时给出了感兴趣区域与焊缝特征点的特写。图 10为第37~40帧的跟踪结果,图 11为第62~65帧的跟踪结果,图 12为强噪声环境下某一帧的跟踪结果。从跟踪结果中可以看出,算法实现了焊缝特征点即焊缝凹槽部分的跟踪,其误差为像素级别。相比于大多数传统方法,本文中提出的方法能够在强噪声甚至噪声完全遮挡焊缝的情况下进行焊缝跟踪,并具有一定的鲁棒性。

同时,本文中共对4组焊缝焊接图片进行了跟踪测试,其跟踪误差如表 1所示。表中记录了每组跟踪结果的平均值、最大值以及均方根(root mean square, RMS)。机器人焊接过程中需要将跟踪误差保持在0.5 mm以内。实验结果显示,本文方法的综合平均误差为0.305 mm,最大跟踪误差为0.479 mm,满足机器人焊接的精度要求。

表 1 特征点跟踪误差Table 1. Tracking errors of feature pointsgroup number of welding average/mm maximum/mm RMS/mm 1 0.279 0.421 0.311 2 0.312 0.476 0.342 3 0.286 0.378 0.327 4 0.341 0.479 0.374 3.2 跟踪漂移修正

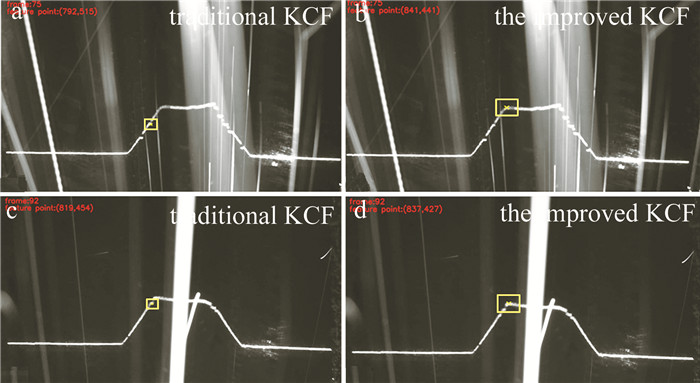

采用原始KCF方法时,如果焊缝特征点被部分遮挡或者完全遮挡,分类器的训练会受到影响进而得到不准确的模板,此模板可能会在后续的跟踪中被不断修正,但也可能会越来越偏离焊缝特征点。图 13a与图 13c为传统KCF算法下出现跟踪漂移的结果,其跟踪的目标已经偏离了焊缝底端。而图 13b与图 13d为改进KCF算法下的跟踪结果,可以看出,原本发生跟踪漂移的帧实现了正确跟踪,充分证明了本文方法在焊缝跟踪中的可行性。

与此同时,计算了处理每帧图像的平均耗时,其结果为28.3 ms,即在像素为1920 pixel×1080 pixel的图像下,本文中提出的算法运行速度约为每秒35帧,能够满足焊接作业的实时要求,甚至可以在更低分辨率下达到数百帧的高速,相比于传统算法有着明显的速度优势。

4. 结论

为了解决焊缝识别与跟踪过程中强噪声带来的干扰,提出了一种基于改进的核相关滤波器的算法来实现焊缝跟踪,完成了以下工作:(a)对焊接的初始帧应用Steger算法来提取焊缝初始帧的激光条纹, 而后对激光条纹通过组合滤波与求导来获取初始帧的焊缝特征点; (b)针对强噪声环境下可能的焊缝被完全遮挡的情况,对KCF算法进行了改进,基于相邻帧之间的相关度响应值来设定阈值,并以此控制分类器模型的更新,最终通过改进的KCF算法跟踪焊缝特征点。

经过实验验证,该算法在强噪声环境下取得了优异的结果,最大跟踪误差为0.479 mm,且引入的峰值相关指数使得焊缝跟踪有效避免了跟踪漂移,具有较高的跟踪准确性与鲁棒性。同时,该算法延续了传统KCF算法的高速性,能够满足实际焊接作业的要求,且对后续焊缝跟踪的研究有一定的指导意义。尽管实验证明了所提出方法的可行性,但在焊缝跟踪的整个过程中仍有一定的改进空间。未来将会进一步研究结合核相关滤波器和深度学习的双阶段焊接特征点跟踪方法。

-

表 1 特征点跟踪误差

Table 1 Tracking errors of feature points

group number of welding average/mm maximum/mm RMS/mm 1 0.279 0.421 0.311 2 0.312 0.476 0.342 3 0.286 0.378 0.327 4 0.341 0.479 0.374 -

[1] ROUT A, DEEPAK B, BISWAL B B. Advances in weld seam tracking techniques for robotic welding: A review[J]. Robotics and Computer-Integrated Manufacturing, 2019, 56: 12-37. DOI: 10.1016/j.rcim.2018.08.003

[2] XU Y, FANG G, LV N, et al. Computer vision technology for seam tracking in robotic GTAW and GMAW[J]. Robotics and Computer-Integrated Manufacturing, 2015, 32: 25-36. DOI: 10.1016/j.rcim.2014.09.002

[3] DINHAM M, FANG G. Autonomous weld seam identification and localisation using eye-in-hand stereo vision for robotic arc welding[J]. Robotics and Computer-Integrated Manufacturing, 2013, 29: 288-301. DOI: 10.1016/j.rcim.2013.01.004

[4] LIU J, FAN Z, OLSEN S I, et al. Boosting active contours for weld pool visual tracking in automatic arc welding[J]. IEEE Transactions on Automation Science and Engineering, 2015, 14(2): 1096-1108.

[5] XU Y, LV N, FANG G, et al. Welding seam tracking in robotic gas metal arc welding[J]. Journal of Materials Processing Technology, 2017, 248: 18-30. DOI: 10.1016/j.jmatprotec.2017.04.025

[6] BANAFIAN N, FESHARAKIFARD R, MENHAJ M B. Precise seam tracking in robotic welding by an improved image processing approach[J]. The International Journal of Advanced Manufacturing Technology, 2021, 114: 251-270. DOI: 10.1007/s00170-021-06782-4

[7] XIA L, ZHOU J, XUE R, et al. Real-time seam tracking during narrow gap GMAW process based on the wide dynamic vision sensing method[J]. Journal of Manufacturing Processes, 2023, 101: 820-834. DOI: 10.1016/j.jmapro.2023.06.045

[8] ZHANG Z, MALASHKHIA L, ZHANG Y, et al. Design of Gaussian process based model predictive control for seam tracking in a laser welding digital twin environment[J]. Journal of Manufacturing Processes, 2022, 80: 816-828. DOI: 10.1016/j.jmapro.2022.06.047

[9] ZOU Y, ZHU M, CHEN X. A robust detector for automated welding seam tracking system[J]. Journal of Dynamic Systems, Measurement, and Control, 2021, 143(7): 071001. DOI: 10.1115/1.4049547

[10] ZHAO Z, LUO J, WANG Y, et al. Additive seam tracking technology based on laser vision[J]. The International Journal of Advanced Manufacturing Technology, 2021, 116: 197-211. DOI: 10.1007/s00170-021-07380-0

[11] DU R Q, XU Y L, HOU Zh, et al. Strong noise image processing for vision-based seam tracking in robotic gas metal arc welding[J]. The International Journal of Advanced Manufacturing Technology, 2019, 101: 2135-2149. DOI: 10.1007/s00170-018-3115-2

[12] WANG N, ZHONG K, SHI X, et al. A robust weld seam recognition method under heavy noise based on structured-light vision[J]. Robotics and Computer-Integrated Manufacturing, 2020, 61: 101821. DOI: 10.1016/j.rcim.2019.101821

[13] LI J, LI B, DONG L, et al. Weld seam identification and tracking of inspection robot based on deep learning network[J]. Drones, 2022, 6(8): 216. DOI: 10.3390/drones6080216

[14] GU W P, XIONG Z Y, WAN W. Autonomous seam acquisition and tracking system for multi-pass welding based on vision sensor[J]. The International Journal of Advanced Manufacturing Technology, 2013, 69: 451-460. DOI: 10.1007/s00170-013-5034-6

[15] XU Y L, FANG G, CHEN Sh B, et al. Real-time image processing for vision-based weld seam tracking in robotic GMAW[J]. The International Journal of Advanced Manufacturing Technology, 2014, 73: 1413-1425. DOI: 10.1007/s00170-014-5925-1

[16] 李小刚, 富巍. 基于激光测距的机器人焊缝跟踪研究[J]. 装备制造技术, 2018(6): 161-165. LI X G, FU W. Research on robot welding seam tracking based on laser ranging[J]. Equipment Manufacturing Technology, 2018(6): 161-165(in Chinese).

[17] STEGER C. An unbiased detector of curvilinear structures[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1998, 20(2): 113-125. DOI: 10.1109/34.659930

[18] SHAH H N M, SULAIMAN M, SHUKOR A Z, et al. Butt welding joints recognition and location identification by using local thresholding[J]. Robotics and Computer-Integrated Manufacturing, 2018, 51: 181-188. DOI: 10.1016/j.rcim.2017.12.007

[19] 曹学鹏, 张弓, 杨根, 等. 面向三维复杂焊缝的焊接机器人焊缝跟踪方法[J]. 工程科学学报, 2023, 45(2): 310-317. CAO X P, ZHANG G, YANG G, et al. Welding seam tracking method of welding robot oriented to three-dimensional complex welding seam[J]. Chinese Journal of Engineering, 2023, 45(2): 310-317(in Chinese).

[20] HENRIQUES J F, CASEIRO R, MARTINS P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 37(3): 583-596.

[21] KNYAZ V A, ZHELTOV S Y, VISHNYAKOV B V. Robust object tracking techniques for vision-based 3D motion analysis applications[J]. Proceedings of the SPIE, 2016, 9896: 334-342.

[22] ZHOU Y, YANG W, SHEN Y. Scale-adaptive KCF mixed with deep feature for pedestrian tracking[J]. Electronics, 2021, 10(5): 536. DOI: 10.3390/electronics10050536

[23] 吴家洲, 刘君, 施佳文, 等. 激光焊缝图像分割与颜色识别方法研究[J]. 激光技术, 2023, 47(5): 723-728. DOI: 10.7510/jgjs.issn.1001-3806.2023.05.022 WU J Zh, LIU J, SHI J W, et al. Research on image segmentation and color recognition method of laser weld[J]. Laser Technology, 2023, 47(5): 723-728(in Chinese). DOI: 10.7510/jgjs.issn.1001-3806.2023.05.022

[24] FEI Y, GAO G, WU D, et al. Improved KCF algorithm and its application to target lost prediction[C]//2022 4th International Conference on Intelligent Control, Measurement and Signal Processing (ICMSP). New York, USA: IEEE Press, 2022: 996-1000.

下载:

下载: