-

全息图的数值重建是数字全息技术中重要的一环,传统数字全息方法获得重建图需要先将全息图傅里叶变换得到频谱图,取+1级滤波,之后逆傅里叶变换得到复振幅分布,再经过解包裹、位相补偿等操作最后得到重建图。由于传统方法步骤繁琐,且得到的结果易受噪声影响, 因此,需要寻求一种快速高效的重建方法。近些年来,神经网络以及相关算法的提升使得深度学习得以迅猛发展,深度学习凭借自身的方便、快捷以及效果突出等优点迅速在工业、农业、医学等各大领域[1-7]占据一席地位,与此同时,深度学习也为数字全息重建方向带来了巨大的便利[8-12]。WANG等人搭建一种端到端的同轴全息重建网络,该网络对不同全息图的光程差变化具有较强的鲁棒性,同时对参考光束的波前没有要求[13]。WANG等人首次提出了一种一对二的轻量化网络并用于数字全息重建,该网络可以同时重建强度和位相两种全息图[14]。LI等人使用U型网络(U-Net)进行全息重建,结果显示,重建图像没有直流项和孪生项的干扰[15]。XIAO等人在U-Net基础上添加注意力机制(squeeze-and-excitation,SE)对细胞进行超分辨重构[16]。PIRONE等人通过搭建多尺度全卷积上下文聚合网络重建出单个细胞的位相图[17]。LI等人[15]只是进行了模拟实验,缺少了对真实图像测试,而WANG[14]和PIRONE等人[17]做的研究重建速度较慢且重建图像背景杂乱,边缘细节模糊。

为进一步解决重建效率低下问题,改进方法在U-Net框架基础上引入端侧神经网络,在特征提取层中添加高效通道注意力机制(efficient channel attention, ECA),在卷积隐藏层使用泄露修正线性单元(leaky rectified linear unit, LeakyReLU)[18]激活函数,通过一系列对主干特征提取网络优化措施, 实现端到端快速多尺度全息图高质量重建。

-

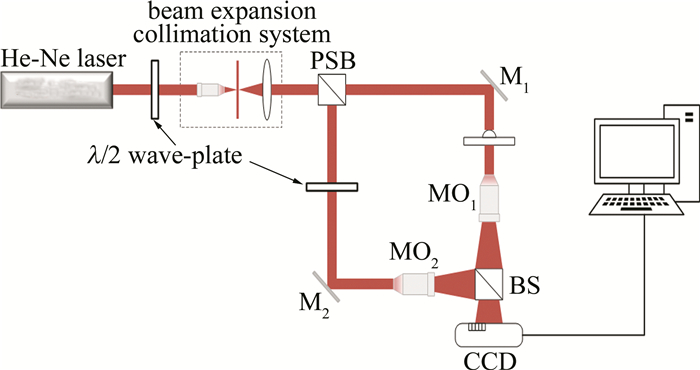

本实验中搭建的光路结构是基于马赫-曾德尔像面数字全息光路,整体结构如图 1所示。所用波长为632.8 nm的He-Ne激光器。激光束通过扩束-滤波-准直系统后经过分束棱镜(patical beam structure, PBS)被分为两束光波,一束经实验样本、显微物镜(microscopic objective, MO)MO1后作为物光波,另一束经显微物镜MO2后作为参考光波,参考光波和物光波在棱镜(beam structure, BS)处合束,最后在输出面上发生干涉叠加生成全息图,电荷耦合器件(charge-coupled device, CCD)传感器采集全息图像并送往计算机[19-20]。

-

实验中所用融合注意力的端侧U型网络(ghost-U-ECA net,GUE-Net)整体结构如图 2所示。网络模型结构呈对称状,整体框架由左边深色特征提取部分以及右边浅色特征融合部分组成。其中,首先图像经过两个端侧块(ghostblock),之后最大池化层(maxpool)与端侧块连续堆叠构成下操作(downpooling, downx),上采样(upsampling)与ghostblock连续堆叠(shorcut)构成上操作(upsampling, upnx),这两者合理编排ghostblock结构用来优化、拓宽层次结构以增强性能。图像输入经过5次maxpool操作后,网络感受野扩大,获得大尺度深层抽象语义信息作为图像特征,ghostblock则通过3×3和5×5线性内核,以廉价操作方式生成相似特征图,其中,3×3和5×5是线性内核,可以降低通用卷积层计算成本,因此能够快速高效提取图像特征。随后经过5次上操作,与特征提取网络相对应,网络输出特征图尺寸以及通道数保持与输入相同,进而保留图像信息的完整性。

ghostblock有两种瓶颈结构[21-22],如图 3所示。主干网络由两个端侧单元(ghost module, GM)连接,GM将提取过程分为两步,第1步是利用1×1卷积(convolution, conv)将通道数压缩至原来的一半; 第2步是压缩特征层经过步长为2×2的深度卷积(depthwise convolution, DWC)层,最后将两者输出进行拼接。GM操作不改变原始特征图宽高[23]。

当步长设置为1×1时,每一个GM后依次是批归一化层(batch normalization, BN)和LeakyReLU激活函数,残差部分不做处理。当步长设置为2×2时,在两个GM之间设置步长为2×2 DWC层,对输出特征层进行宽高压缩,在此期间引入ECA注意力,提高学习能力。残差边部分设置步长为2×2的DWC层和1×1卷积层。残差结构将图像矩阵直接叠加到输出端[24],卷积过程丢失的细节信息得以保留,提高了模型精度,同时DWC层可大幅度减少网络运行参数量,使网络更快重建。

ghostblock选用LeakyReLU激活函数,它不仅在负区域具有小的正斜率,神经元死亡与梯度消失问题得以避免,并且在负区域的梯度具有随机性,这些随机噪声可以帮助超参数α寻找出局部最优点及鞍点,计算效率加以提升,下式为激活函数计算公式:

$ L(x)=\left\{\begin{array}{l} x, (x>0) \\ \alpha x, (x \leqslant 0) \end{array}\right. $

(1) 式中,x为输入,α为比例系数。

ZHANG等人通过压缩和激励网络(squeeze-and-excitation networks, SE-Net)的变种网络对比实验证明,SE-Net在进行通道维度降低时, 会使得通道和权重不再直接对应,从而导致网络性能受损[25]。考虑到受损原因,ECA模块在SE-Net基础上使用两种优化方法,分别是无降维的跨通道交互策略和自适应确定1维卷积核方法[26-27]。运用局部跨道信息交互能够使得通道与权重相对应,共享权重信息,提升网络学习感兴趣区域(region of interest, ROI)能力,从而忽略对背景特征学习,由此提高模型精度。

图 4为ECA模块示意图。图中,C、H、W分别为输入图像的通道数、高和宽,k表示1维卷积的内核大小,GAP为全局平均池化(global average pooling),σ为s型激活函数,⊗为相乘符号。

自适应确定k的大小在很大程度上节省大量算力资源,下式为自适应确定k方法:

$ k=\varPsi(C)=\left|\frac{\mathrm{lb} C}{\gamma}+\frac{b}{\gamma}\right|_{\text {odd }} $

(2) 式中,k为内核大小,表示跨通道交互的区域,即有多少个相近邻参与一个通道的注意力预测,Ψ(C)表示对C的一种线性映射,C为通道数,|·|odd表示最近邻奇数,γ为线性映射的斜率,取值为2,b为线性映射的截距,取值为1。

-

数据集制作流程如下:通过图 1光路采集血细胞和鸡血细胞全息图;使用滤波半径为30的低通滤波法将采集到的全息图进行下采样,并加入方差为0.03的高斯噪声模拟实际的低分辨图像,获得1024×1024尺寸的低分辨率全息图。训练集过少会造成网络特征提取不充分、过拟合、网络不能收敛等问题,因此,为增强模型泛化能力,将低分辨率全息图样本随机裁剪成256×256像素大小,并将图像随机水平或纵向翻转,或者同时施加两种变换以扩充数据集。共获得血细胞全息图 3500张,鸡血细胞全息图 2000张,以4∶1比例划分数据集为训练集和测试集;使用数字全息角谱重建方法对训练集中原始全息图进行重建,其结果作为训练标签;低分辨率全息图与角谱重建位相图一一对应送入GUE-Net网络训练。在完成重建位相训练结束后再按照上述方法制作角谱重建强度图并送入网络训练。

实验流程如图 5所示。

-

网络初始学习率调为0.001,在训练中自主调节学习率;选用自适应矩估计算法优化器;batch大小设为14,在每一次小批量训练中,weights和bias会在一次迭代优化后自动更新,训练过程在150次迭代后完成。训练采用平滑的L1范数损失函数,优点在于无论真实值和预测值的差别较小或较大,所计算得到的梯度值都非常小,因此,在训练过程中零点不平滑问题能够很好地解决,并且该损失函数对于异常值的鲁棒性更强。该损失函数表达式为:

$ S(x)=\left\{\begin{array}{l} 0.5 x^2, (|x|<1) \\ |x|-0.5, (\text { otherwise }) \end{array}\right. $

(3) 式中,x为损失函数的输入。

-

实验中采用结构相似性指数(structure similarity index measure, SSIM)和峰值信噪比(peak signal-to-noise ratio, PSNR)作为重建网络性能的评价标准。计算公式如下所示:

$ S_{\mathrm{SSIM}}(\boldsymbol{x}, \boldsymbol{y})=\frac{\left(2 \boldsymbol{\mu}_x \boldsymbol{\mu}_y+c_1\right)\left(2 \boldsymbol{\sigma}+c_2\right)}{\left(\boldsymbol{\mu}_{\boldsymbol{x}}{ }^2+\boldsymbol{\mu}_y{ }^2+c_1\right)\left(\boldsymbol{\sigma}_x{ }^2+\boldsymbol{\sigma}_y{ }^2+c_2\right)} $

(4) $ M_{\mathrm{SE}}(i, j)=\frac{1}{m n} \sum\limits_{i=0}^{m-1} \sum\limits_{j=0}^{n-1}\|I(i, j)-K(i, j)\|^2 $

(5) $ R_{\mathrm{PSNR}}(i, j)=10 \lg \left(\frac{\left(2^n-1\right)^2}{M_{\mathrm{SE}}(i, j)}\right) $

(6) 式中,x和y为两个需要对比的输入图片,σx和σy是图像像素方差,μx和μy是图像像素均值,σ是图像像素协方差,c1和c2是限制常数,作用是防止分母为0,m和n分别是图像的长和宽,I(i, j)为未压缩的原始图像的像素值,K(i, j)是I经过压缩后的图像的像素值。PSNR是在均方误差(mean squared error, MSE)上增加了对数运算。

从表 1、表 2可知,改进网络所得到的SSIM、PSNR评价指标结果均优于U-Net网络,并且重建单张图像的时间均有缩短。

表 1 不同网络测试强度性能结果

Table 1. Intensity performance results of different network tests

blood cells chicken blood cells model SSIM PSNR time/s SSIM PSNR time/s U-Net 0.9559 19.12 0.035 0.9547 19.54 0.050 GUE-Net 0.9613 27.38 0.030 0.9654 22.62 0.048 表 2 不同网络测试位相性能结果

Table 2. Phase performance results of different network tests

blood cells chicken blood cells model SSIM PSNR time/s SSIM PSNR time/s U-Net 0.9038 21.02 0.038 0.9512 21.26 0.080 GUE-Net 0.9417 26.77 0.033 0.9734 23.48 0.068 -

测试集随机选取图片进行测试,图 6、图 7分别为血细胞和鸡血细胞超分辨重建结果。从左到右依次是细胞低分辨率全息图、重建超分辨强度图、重建位相2维图以及位相3维图展示。由图中细节可以看出,改进方法重建后的图像,边缘和纹理清晰可见,细胞背景较为平坦。图中右端色度条为光谱条,代表相位,单位是rad。

为定量验证改进方法的优势,利用网络输出图和传统重建方法误差图对照细节信息。依次为血细胞强度误差图、血细胞位相误差图、鸡血细胞强度误差图、鸡血细胞位相误差图。结果如图 8所示,经GUE-Net重建后误差较小,能够明显提升输入样本与真实高分辨图重建的相似程度。图中右端色度条为光谱条,代表相位,单位是rad。

-

在数据集中训练集数据图片大小都是256×256像素,但是实际情况中采集的全息图视场较大,在此网络中测试集不限制尺度大小,无论采集的全息图具有多大尺度,由256×256像素大小训练集训练得到的模型都可以进行超分辨重建。图 9是3种不同尺度重建结果。可以看出,改进方法对细胞图像细节进行了位相补偿,使得背景更为平坦,细胞边缘更清晰。

-

噪声在获取全息图像过程中不可避免地出现,因此测试改进网络的抗噪声性能。依次加入方差等级为0.01,0.05,0.1,0.15和0.2的噪声作为低分辨率图像测试,输出结果如图 10所示。在0.2噪声等级的时候还能重建出较清晰的图像,可知此网络有一定的抗噪性,进一步进行定量分析。

-

损失函数是用来衡量网络的预测值与真实值的差异程度的运算函数。为验证损失函数对网络性能的影响,进行了3组不同损失函数的超分辨重建实验,用均方误差损失函数和L1范数损失函数,与改进网络中使用的损失函数S(x)做对照实验,在相同训练条件以及相同测试集下观察PSNR和SSIM数值的变化。以血细胞为例,结果如表 3所示。不难看出,重建网络采用损失函数S(x)时,PSNR和SSIM数值均最高,网络的性能得以最大化提升。

表 3 不同损失函数位相和强度重建效果

Table 3. Phase and intensity reconstruction effects of different loss functions

phase intensity SSIM PSNR SSIM PSNR L1 loss function 0.8562 25.47 0.9577 26.16 mean squared error loss function 0.8954 24.29 0.9601 25.38 S(x) 0.9415 26.77 0.9756 27.38 -

基于U-Net框架提出了一种端到端超分辨重建GUE-Net网络,该网络输入低分辨率全息图,可直接重建出对应全息图的超分辨位相与强度分布。实验对血细胞和鸡血细胞生物样品进行测试以证明改进网络可行性。经重建图、3维图、误差图以及抗噪性实验结果对照显示,改进网络能够重建出较好的图像纹理和边缘细节,同时改进网络对于多种尺度全息图进行重建,结果表明,GUE-Net具有良好的稳定性与鲁棒性。

基于深度学习的全息图超分辨重建研究

Superresolution reconstruction of holograms based on deep learning

-

摘要: 为了避免传统全息重建方法步骤繁杂且重建效果易受噪声干扰等问题, 采用一种改进的语义分割U型网络用于全息图超分辨重建工作。首先引入新型的端侧神经网络, 用来充分获取更多的图像语义信息, 增强网络学习性能; 其次加入深度神经卷积网络的高效通道注意力以提高网络关注全息图中细节信息的能力, 进一步提升网络精度, 同时采用带泄露修正线性单元作为激活函数, 加快网络收敛; 并采用血细胞和鸡血细胞的低分辨率全息图进行训练, 取得了超分辨重建强度和位相图。结果表明, 改进网络能够快速重建出细节信息丰富、边缘纹理清晰、背景平坦的位相和强度图像, 血细胞强度重建图的结构相似性指数和峰值信噪比分别达到0.9613和27.38, 同时可对不同尺度的全息图进行重建。该研究为使用深度学习方法提高全息图质量提供了参考。Abstract: In order to avoid the problems of complicated steps and noise interference of traditional holographic reconstruction methods, an improved semantic segmentation U-Net network was used for super-resolution reconstruction of holograms. Firstly, a novel end-to-end neural network was introduced to fully acquire more semantic information of images and to enhance the performance of network learning. Secondly, the efficient channel attention (ECA) of deep neural convolutional network was added to improve the ability of focusing on details in the holograms, and to further improve the accuracy of the network. The leaky rectified linear units (LeakyReLU) was used as the activation function to accelerate the network convergence. Using the low resolution holograms of blood cells and chicken blood cells for training, the super-resolution reconstruction intensity and phase map were obtained. The results show that the improved network can quickly reconstruct the phase and intensity images with rich details, clear edge texture and flat background. The structure similarity index measure (SSIM) and peak signal-to-noise ratio (PSNR) of the blood cell intensity reconstruction images are 0.9613 and 27.38, respectively. Meanwhile, the holograms of different scales can be reconstructed. This study provides a reference for using deep learning to improve the quality of holograms.

-

表 1 不同网络测试强度性能结果

Table 1. Intensity performance results of different network tests

blood cells chicken blood cells model SSIM PSNR time/s SSIM PSNR time/s U-Net 0.9559 19.12 0.035 0.9547 19.54 0.050 GUE-Net 0.9613 27.38 0.030 0.9654 22.62 0.048 表 2 不同网络测试位相性能结果

Table 2. Phase performance results of different network tests

blood cells chicken blood cells model SSIM PSNR time/s SSIM PSNR time/s U-Net 0.9038 21.02 0.038 0.9512 21.26 0.080 GUE-Net 0.9417 26.77 0.033 0.9734 23.48 0.068 表 3 不同损失函数位相和强度重建效果

Table 3. Phase and intensity reconstruction effects of different loss functions

phase intensity SSIM PSNR SSIM PSNR L1 loss function 0.8562 25.47 0.9577 26.16 mean squared error loss function 0.8954 24.29 0.9601 25.38 S(x) 0.9415 26.77 0.9756 27.38 -

[1] ZHANG X, CHEN Zh K, GAO J, et al. A two-stage deep transfer learning model and its application for medical image processing in traditional medicine[J]. Knowledge-Based Systems, 2022, 239(5): 108060. [2] HOLTKAMP A, ELHENNAWY K, ORO J, et al. Clinical medicine generalizability of deep learning models for caries detection in near-infrared light transillumination images[J]. Journal of Clinical Medicine, 2021, 10(5): 961. doi: 10.3390/jcm10050961 [3] 张艳月, 张宝华, 赵云飞, 等. 基于双通道深度密集特征融合的遥感影像分类[J]. 激光技术, 2021, 45(1): 73-79. ZHANG Y Y, ZHANG B H, ZHAO Y F, et al. Remote sensing image classification based on dual-channel deep dense feature fusion[J]. Laser Technology, 2021, 45(1): 73-79(in Chinese). [4] XUE H L, CHEN X, ZHANG R, et al. Deep learning-based maritime environment segmentation for unmanned surface vehicles using superpixel algorithms[J]. Journal of Marine Science and Engineering, 2021, 9(12): 1329. doi: 10.3390/jmse9121329 [5] MA G, LLANESl A, IMBERNON B, et al. Performance evaluation of edge-computing platforms for the prediction of low temperatures in agriculture using deep learning[J]. The Journal of Supercomputing, 2021, 77(9): 1-23. [6] WU Y F, WU J C, HAO R, et al. Research progress of particle field digital holography based on deep learning[J]. Journal of Applied Optics, 2020, 41(4): 662-674. doi: 10.5768/JAO202041.0409003 [7] 向东, 桂进斌, 刘超, 等. 数字全息波前准确重建的实验研究[J]. 激光技术, 2017, 41(3): 406-410. XIANG D, GUI J B, LIU Ch, et al. Experiment research of accurate wavefront reconstruction of digital holography[J]. Laser Technology, 2017, 41(3): 406-410(in Chinese). [8] LIU Y P, ZHANG T, SU J, et al. Reconstruction resolution enhancement of epism based holographic stereogram with hogel spatial multiplexing[J]. Chinese Physics, 2022, 31(4): 310-319. [9] LI F Q, ZHAO M, TIAN Z M, et al. Compressive ghost imaging through scattering media with deep learning[J]. Optics Express, 2020, 28(12): 17395-17408. doi: 10.1364/OE.394639 [10] YIN D, GU Z Z, ZHANG Y R. Digital holographic reconstruction based on deep learning framework with unpaired data[J]. IEEE Photonics Journal, 2020, 12(2): 1-12. [11] WU Y C, RIVENSON Y, ZHANG Y B, et al. Extended depth-of-field in holographic imaging using deeplearning-based autofocusing and phase recovery[J]. Optica, 2018, 5(6): 704-710. doi: 10.1364/OPTICA.5.000704 [12] REN Zh B, XU Zh M, LAM E Y M. End-to-end deep learning framework for digital holographic reconstruction[J]. Advanced Photonics, 2019, 1(1): 016004. [13] WANG H, LYU M, SITU G. eHoloNet: A learning-based end-to-end approach for in-line digital holographic reconstruction[J]. Optics Express, 2018, 26(18): 22603-22614. doi: 10.1364/OE.26.022603 [14] WANG K Q, DOU J Z, QIAN K M, et al. Y-Net: A one-to-two deep learning framework for digital holographic reconstruction[J]. Optics Letters, 2019, 44(19): 4765-4768. doi: 10.1364/OL.44.004765 [15] 李菊, 李军. 基于U-Net网络的单幅全息图重建方法研究[J]. 激光杂志, 2020, 41(1): 96-99. LI J, LI J. Research on single hologram reconstruction method based on U-Net network[J]. Laser Journal, 2020, 41(1): 96-99(in Chin-ese). [16] 肖文, 李解, 潘锋, 等. 基于USENet实现数字全息细胞再现相位像超分辨重构[J]. 光子学报, 2020, 49(6): 173-184. XIAO W, LI J, PAN F, et al. Super-resolution in digital holographic phase cell image based on usenet[J]. Acta Photonica Sinica, 2020, 49(6): 173-184(in Chinese). [17] PIRONE D, SIRICO D, MICCIO L, et al. Speeding up reconstruction of 3D tomograms in holographic flow cytometry via deep learning[J]. Lab on a Chip, 2022, 22(4): 793-804. doi: 10.1039/D1LC01087E [18] NAYFE B H, ABDULLAH S N H S, SULAIMAN R, et al. Optimized leakyrelu for handwritten arabic character recognition using convolution neural networks[J]. Multimedia Tools and Applications, 2022, 81(2): 2065-2094. doi: 10.1007/s11042-021-11593-6 [19] 刘飞飞. 数字全息显微中的高精度位相重建算法及实验研究[D]. 邯郸: 河北工程大学, 2014: 42-124. LUI F F. Investigation of exact phase reconstruction algorithm and expeiments in digital holographic microscopy[D]. Handan: Hebei University of Engineering, 2014: 42-124(in Chinese). [20] 宋修法, 于梦杰, 王华英, 等. 物光与参考光强度比对数字全息再现像质的影响[J]. 激光技术, 2014, 38(6): 859-862. SONG X F, YU M J, WANG H Y, et al. Effect of reference intensity ratio to object on reconstructed image quality in digital holography[J]. Laser Technology, 2014, 38(6): 859-862(in Chinese). [21] HAN K, WANG Y, XU C, et al. Ghostnets on heterogeneous devices via cheap operations[J]. International Journal of Computer Vision, 2022, 130(4): 1050-1069. doi: 10.1007/s11263-022-01575-y [22] LIU H, LI D, JIANG B, et al. Mgbn-yolo: A faster light-weight object detection model for robotic grasping ofbolster spring based on image-based visual servoing[J]. Journal of Intelligent & Robotic Systems, 2022, 104(4): 77. [23] WEI B, SHEN X, YUAN Y. Remote sensing scene classification based on improved ghostnet[J]. Journal of Physics Conference Series, 2020, 1621(1): 012091. doi: 10.1088/1742-6596/1621/1/012091 [24] WEI Y, YUAN Q, SHEN H, et al. Boosting the accuracy of multispectral image pansharpening by learning a deep residual network[J]. Geoscience and Remote Sensing Letters, 2017, 14(10): 1795-1799. [25] JIANG Y, CHEN L, ZHANG H, et al. Breast cancer histopathological image classification using convolutional neural networks with small se-resnet module[J]. Plos One, 2019, 14(3): 10214587. [26] 毛志荣, 都云程, 肖诗斌, 等. 基于ECA-Net与多尺度结合的细粒度图像分类方法[J]. 计算机应用研究, 2021, 38(11): 3484-3488. MAO Zh R, DU Y Ch, XIAO Sh B, et al. Fine-grained image classification method based on ECA-net and multi-scale[J]. Application Research of Computers, 2021, 38(11): 3484-3488(in Chinese). [27] XUE H, SUN M H, LIANG Y H. ECANet: Explicit cyclic attention-based network for video saliency prediction[J]. Neurocomputing, 2022, 468(C): 233-244. -

网站地图

网站地图

下载:

下载: